aliases:

- GMNGraph Mamba Networks

Graph Mamba Networks (GMNs),一种新的基于状态空间模型的图神经网络。被认为是消息传递神经网络和Graph Transformer的改进。

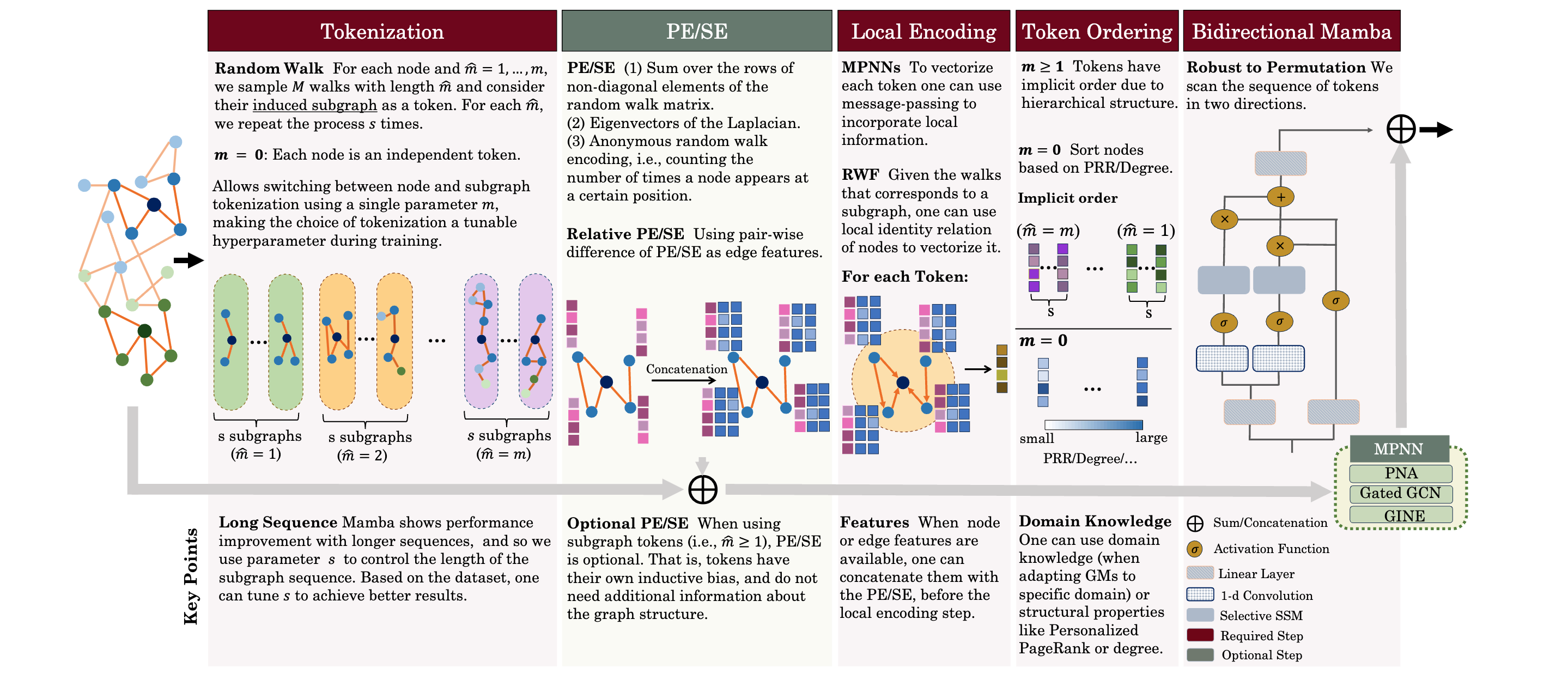

GMN 需要四个必须步骤和一个可选步骤

- Tokenization:将图映射到一个 token 序列。

- PE/SE:可选,通过关于节点位置和图结构的信息传递误差

- 局部编码:通过子图向量化机制,将每个节点周围的局部结构编码

- Token 排序:通过上下文对 token 进行拍去

- 双向 Mamba:扫描并选择相关的节点或子图来输入隐藏状态

挑战

序列和二维数据

Mamba 期望的输入为因果数据,因此对于二维的图结构数据处理起来比较棘手。需要某种对 token 的排序机制。

长序列建模

在图领域中,token序列,如节点,边和子图,都可以作为认为是序列。但 Transformer 无法处理长序列。但 Mamba 可以有效过滤不相关信息,任何时刻都可以重制其状态。

此外,随着序列增长,其表现也得到了提升。

可扩展性

由于图结构的复杂性,Transformer 和 Mamba 这类的序列编码器都要求恰当的位置和就够编码,这一过程通常是二次计算复杂度,导致训练起来非常困难

子图尺度

Graph Mamba Networks

设图

对于节点

Tokenization

将图映射为 token 序列。这里引入了一种新的 Tokenization 方式。首先对每个节点采样一些能够表征此节点的邻居关系,局部和全局位置的子图,然后将这些子图向量化来得到其节点表示

邻节点采样

对于给定的节点

由于之间提到,SSSM 的性能随着序列长度而提升,因此对应的,我们可以重复此采样过程

可选的结构/位置编码

PE 是为了提供节点在图中的位置信息,在图中相近的两个节点的 PE 和 SE 应该是相近的。

其中

邻节点编码

给定节点

其中

Token 排序

由于状态空间模型这类序列模型需要输入的 token 是序列的,因此需要构建合适的顺序。尤其是 Mamba 的

令当